Le dilemme de la voiture autonome

Cité des Sciences et de l'Industrie

-

24/06/2016 14:00:00

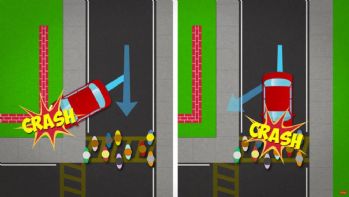

En cas d’accident imminent, l'intelligence artificielle doit-elle privilégier la sécurité des passagers ou celle des piétons ?

Même si elles n’en sont qu’au stade expérimental, les voitures autonomes nous promettent moins d’embouteillage, moins de pollution et aussi moins d’accidents. Mais avec ces nouveaux véhicules, un dilemme cornélien risque de se poser. En cas d’accident imminent, l’intelligence artificielle doit-elle privilégier la sécurité des passagers ou celle des piétons ou des autres conducteurs ? Cela revient à introduire un code moral dans la caboche de ces robots…

Afin d’engager une réflexion sur cette problématique, Jean-François Bonnefon, de l’université de Toulouse, et ses collègues de l’université de l’Oregon et du MIT, aux États-Unis, présentent dans la revue Science les résultats d’une étude menée auprès de 2 000 résidents américains. À travers une série d’enquêtes en ligne, les chercheurs ont demandé aux sujets de se prononcer sur la décision que devrait tenir le véhicule autonome en cas d’accident imminent. Plusieurs scénarios ont été présentés, faisant varier les types d’accidents, le nombre de voitures, de piétons ou de passagers, la nature des obstacles : des humains, des chiens, des chats, etc.

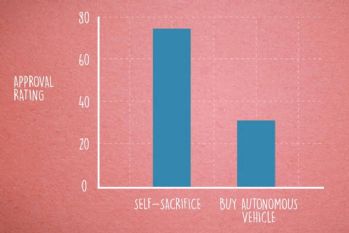

Achèteriez-vous une voiture prête à vous sacrifier ?

Les sujets ont jugé à 75 % que les voitures autonomes devaient être programmées pour sacrifier le conducteur plutôt que les piétons. Ce qui d’un point de vue moral paraît plutôt acceptable. En revanche, les mêmes personnes estiment que si elles avaient le choix, elles n’achèteraient pas de véhicules intelligents susceptibles de les sacrifier.

Bref, le problème semble pour l’instant sans solution. Alors que de nombreux experts estiment que les véhicules autonomes pourraient réduire le nombre d’accidents, inculquer un code moral à ces machines pourrait surtout freiner leur adoption. On attend la réponse des constructeurs face à ce sérieux dilemme.